Após investigação, Apple remove apps que “tiram a roupa” de pessoas com uso de IA

A investigação foi feita pela BBC

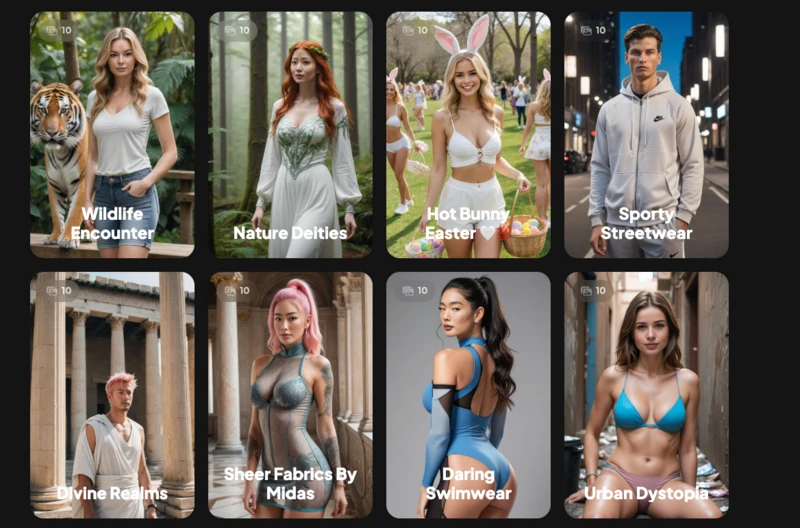

Após uma investigação feita pela BBC, a Apple removeu diversos aplicativos que “tiram a roupa” de pessoas através do uso de IA da App Store. A tecnologia, conhecida como “deepfake”, cria fotos da pessoa nua sem seu consentimento.

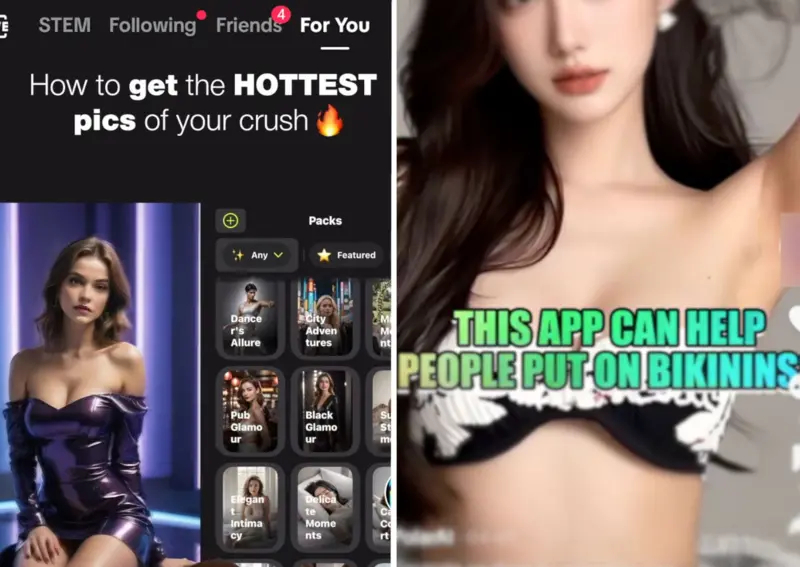

Segundo a BBC, os aplicativos diziam ser uma forma de “apimentar selfies”, mas nos anúncios em redes sociais, como o TikTok, eles eram promovidos como uma forma de criar imagens de cunho sexual de mulheres sem permissão.

Veja as fotos

Leia Também

Os “deepfakes” viraram um problema mundial, e diversos escândalos, alguns envolvendo pessoas menores de idade, já repercutiram em diversos países, como Coréia do Sul, Espanha e Estados Unidos. Eles também são usados para chantagear indivíduos e famílias.

Arvind Narayanan, professor do Centro de Política da Tecnologia da Informação de Princeton, disse: “Deveria haver muito mais barreiras para impedir o acesso a essa tecnologia”.

Através dos anúncios no TikTok, a BBC identificou quatro aplicativos diferentes, que foram removidos da App Store pela Apple. O criador de um dos apps afirmou que não tinha a intenção de anunciá-lo como ferramenta de criação de “deepfakes”.

Fique por dentro!

Para ficar por dentro de tudo sobre o universo dos famosos e do entretenimento siga @leodias no Instagram.

Agora também estamos no WhatsApp! Clique aqui e receba todas as notícias e conteúdos exclusivos em primeira mão.